メタ社はシカゴ大学およびカリフォルニア大学バークレー校の研究者と共同で、強化学習(RL)を使用して大規模言語モデル(LLM)エージェントを訓練する際に直面する高コスト、複雑なインフラ、信頼性の低いフィードバックなどの問題を解決する新しいフレームワーク「DreamGym」を開発しました。DreamGymはRL環境をシミュレーションすることで、エージェントを効率的に複雑なアプリケーション処理に導きます。

DreamGymはトレーニング中にタスクの難易度を動的に調整し、エージェントが段階的により挑戦的な問題を解決できるようにします。研究チームの実験によると、完全なシミュレーション環境において、そしてシミュレーション学習を現実世界に応用する場面でも、DreamGymはRLトレーニングの効果を顕著に向上させました。一部のRLが応用可能ながコストが高い環境では、DreamGymは合成されたインタラクションのみで一般的なアルゴリズムと同等の性能を達成でき、データ収集や環境とのインタラクションのコストを大幅に削減できます。

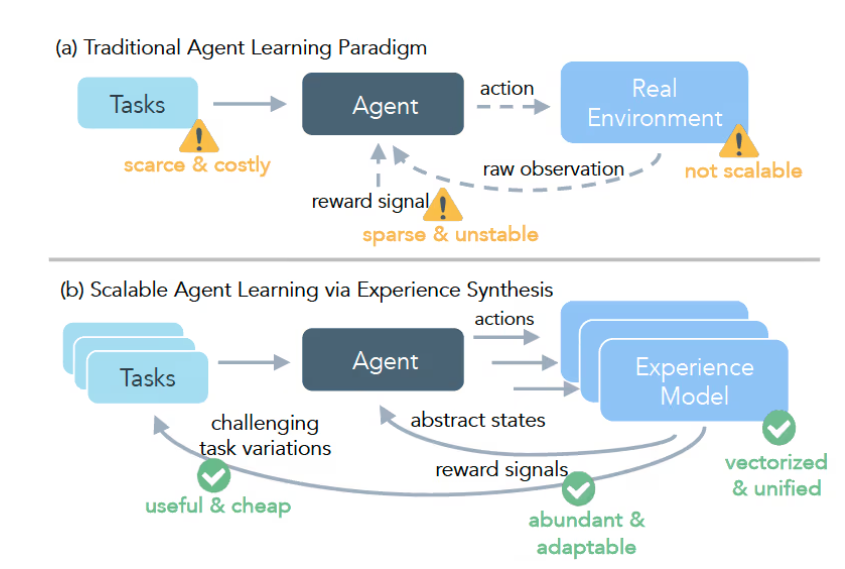

強化学習を使ってLLMエージェントをトレーニングするにはさまざまな課題があります。現実的な応用では、長い操作のシーケンスやスパースなフィードバックが通常です。エージェントは一連の正しい操作を経て初めてポジティブなサインを得ます。また、十分な多様性を持ち、検証されたデータを収集するのは費用がかかり、多くの場合、人間の専門家による検証やラベリングが必要です。これらの問題を解決するために、DreamGymは効果的かつ安全なトレーニングパスを提供します。

DreamGymフレームワークのコアは3つの部分から構成されています。第一は「推論に基づく経験モデル」であり、これは目標環境のダイナミクスをテキスト空間に変換し、アプリケーション環境をシミュレートします。第二は「経験のリプレイバッファ」であり、動的なメモリーバックとして、経験モデルの予測を補助し、合成された経験の多様性を確保します。第三は「カリキュラムタスクジェネレーター」であり、エージェントのパフォーマンスに基づいて新たな、より困難なタスクを自動生成します。この3つは協力して閉じたシステムを形成し、効率的なエージェントトレーニングを実現します。

研究者はDreamGymに対して複数のベンチマークテストを行いました。これは電子商取引、感覚制御、リアルなウェブインターフェースなど、さまざまな分野を含んでいます。結果は、DreamGymがすべてのタスクで優れたパフォーマンスを示したことを示しており、特にWebArena環境では、トレーニングされたエージェントの成功率はベースライン方法よりも30%以上高いことが確認されました。このような形で、DreamGymはこれまで実現が難しいとされていた分野にも実用的なRLトレーニングの解決策を提供しています。

ポイント:

🌟 DreamGymはシミュレーション環境でAIエージェントをトレーニングし、RLトレーニングのコストとリスクを下げます。

🚀 このフレームワークはタスクの難易度を動的に調整し、エージェントがより複雑な問題を段階的に解決できるようにします。

💡 実験結果は、DreamGymがさまざまな応用分野で従来のトレーニング方法よりも優れていることを示しています。