最近、中国の研究者たちは「DeepEyesV2」というマルチモーダル人工知能モデルを発表しました。このモデルは画像を分析し、コードを実行し、インターネット検索を行うことができます。従来のモデルがトレーニング中に得た知識に依存するのとは異なり、DeepEyesV2は外部ツールをスマートに活用することで、多くの場合でより大規模なモデルを上回る性能を示しています。

初期の実験では、研究チームは強化学習だけではツールを安定して使用することができないことに気づきました。最初の段階では、モデルは画像分析用のPythonコードを書こうと試みましたが、頻繁に誤ったコードスニペットを生成していました。トレーニングが進むにつれて、モデルはツールの使用を完全に回避するようになっていきました。

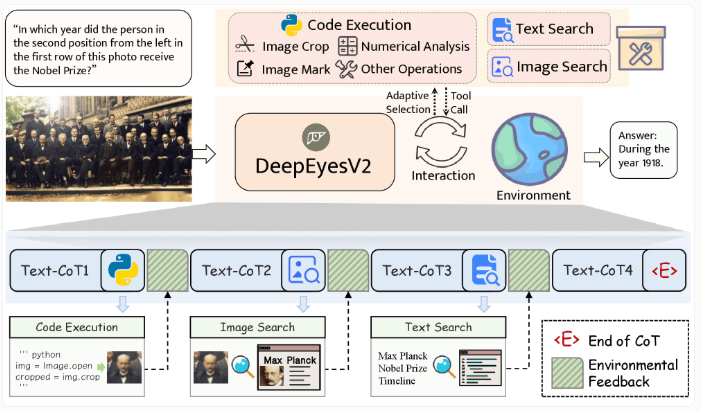

この問題を解決するために、研究チームは二段階のトレーニングプロセスを開発しました。第一段階では、モデルは画像理解とツールの使用を組み合わせて学習します。第二段階では、強化学習を利用してこれらの行動を最適化します。研究者は優れたモデルを使って高品質な例を生成することで、ツールの使用経路の正確性と明確さを確保しました。

DeepEyesV2は、マルチモーダルタスクを処理するために3つのツールカテゴリを使用します。コード実行は画像処理や数値分析に使われ、画像検索は類似したコンテンツを検索するため、テキスト検索は画像には見えない文脈情報を提供します。モデルは画像操作、Pythonの実行、画像/テキスト検索を統合することで、さまざまなクエリに対応します。

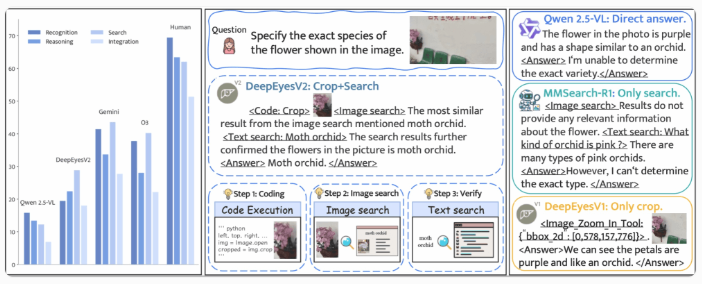

この方法を評価するために、研究チームはRealX-Benchベンチマークテストを作成しました。これは視覚的理解、インターネット検索、推論の協調能力を検証するためのものです。研究結果によると、最も高性能な専有モデルでも正確率は46%にとどまり、人間の正確率は70%でした。3つのスキルを同時に使うタスクでは、現在のモデルのパフォーマンスは不十分であることがわかりました。

DeepEyesV2は複数のベンチマークテストで優れた性能を発揮しており、数学的推論タスクでは正確率が52.7%、検索駆動型タスクでは63.7%に達しました。これは、丁寧に設計されたツールの使用により、小さなモデルの限界を補うことができるということを示しています。

DeepEyesV2は現在、Hugging FaceとGitHubで公開されており、Apache License 2.0により商業利用が可能です。これにより、マルチモーダルAIの発展がさらに推進されています。

論文:https://arxiv.org/abs/2511.05271

ポイント:

🌟 DeepEyesV2は、スマートなツールを活用してマルチモーダルタスクの性能を向上させ、大型モデルを上回っています。

🔧 二段階のトレーニングプロセスを採用し、画像理解とツールの使用を組み合わせています。

📈 複数のベンチマークテストで優れた性能を発揮し、小さなモデルの潜在力を示しています。