Meta 公司與芝加哥大學及加州大學伯克利分校的研究人員共同開發了一種新框架 ——DreamGym,旨在解決使用強化學習(RL)訓練大型語言模型(LLM)代理所面臨的高成本、複雜基礎設施和不可靠反饋等問題。DreamGym 通過模擬 RL 環境來訓練代理,使其能夠高效地處理複雜應用程序。

DreamGym 在訓練過程中能夠動態調整任務難度,確保代理逐步學習並解決更具挑戰性的問題。研究團隊的實驗表明,DreamGym 在完全模擬的環境下,以及需要將模擬學習應用於現實世界的場景中,都顯著提升了 RL 訓練的效果。在一些 RL 可以應用但成本高昂的環境中,DreamGym 能夠僅依靠合成交互就達到與流行算法相媲美的性能,極大降低了數據收集和環境交互的成本。

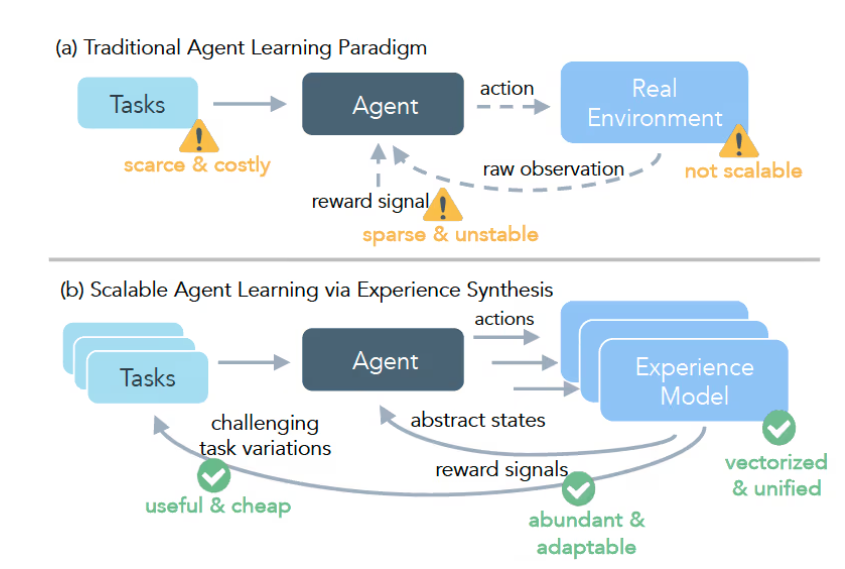

使用強化學習訓練 LLM 代理面臨多種挑戰,現實應用通常涉及長時間的操作序列和稀疏反饋,代理只有在經歷一系列正確操作後才能獲得正面信號。此外,收集足夠多樣和經過驗證的數據也很昂貴,往往需要人類專家進行驗證和標註。爲了解決這些問題,DreamGym 提供了一種有效且安全的訓練路徑。

DreamGym 框架的核心由三個部分組成:第一是 “基於推理的經驗模型”,它將目標環境的動態轉換爲文本空間,模擬應用環境。第二是 “經驗重放緩衝區”,作爲動態記憶庫,幫助指導經驗模型的預測,確保合成經驗的多樣性。第三是 “課程任務生成器”,根據代理的表現自動生成新的、更具挑戰性的任務。這三者協同作用,形成了一個封閉的系統,實現了高效的代理訓練。

研究者對 DreamGym 進行了多項基準測試,包括電子商務、體感控制和真實網頁交互等領域,結果顯示 DreamGym 在各類任務中均表現優越,尤其在 WebArena 環境下,訓練出的代理成功率超過基線方法30% 以上。通過這種方式,DreamGym 爲以往難以實現的領域提供了可行的 RL 訓練解決方案。

劃重點:

🌟 DreamGym 通過模擬環境訓練 AI 代理,降低了 RL 訓練的成本和風險。

🚀 該框架動態調整任務難度,使代理能夠逐步解決更復雜的問題。

💡 實驗結果表明,DreamGym 在多種應用領域中表現優於傳統訓練方法。