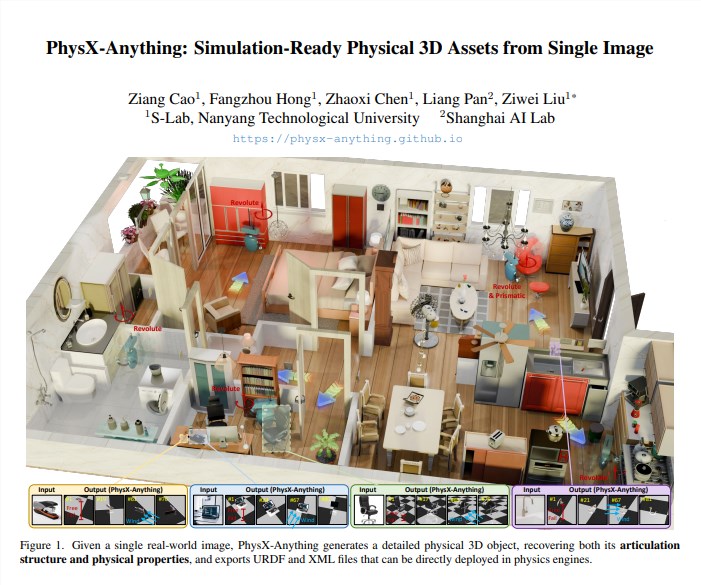

南洋理工大學與上海人工智能實驗室聯合發佈開源框架 PhysX-Anything,只需一張 RGB 圖像即可輸出帶幾何、關節、物理參數的完整3D 資產,可直接導入 MuJoCo、Isaac Sim 進行機器人策略訓練。

技術亮點

1. 由粗到細 pipeline:先預測整體物理屬性(質量、質心、摩擦係數),再部件級細化幾何與關節極限角度,避免“視覺優先”導致的物理失真。

2. 新型壓縮3D 表示:把面片+關節軸+物理屬性編碼進8K 維隱向量,推理時一次解碼,生成速度較 SOTA 提升2.3倍。

3. 顯式物理監督:在數據集里加入12萬組真實物理測量,訓練階段引入質心、慣量與碰撞盒損失,確保仿真一致性。

實測結果

在 Geometry-Chamfer 與 Physics-Error 雙指標上,PhysX-Anything 分別降低18% 與27%;絕對尺度誤差 <2cm,關節運動範圍誤差 <5°,顯著優於 ObjPhy、PhySG 等最新方法。真實場景測試(宜家傢俱、廚房用具)中,生成資產導入 Isaac Sim 後,機器人抓取成功率提升12%,訓練步數減少30%。

開源與影響

項目已上線 GitHub,權重、數據和評測基準同步開放;團隊計劃2026Q1發佈支持「視頻輸入」的 V2版,可預測可動部件時序軌跡,爲動態場景策略學習提供支持。

論文:https://arxiv.org/pdf/2511.13648