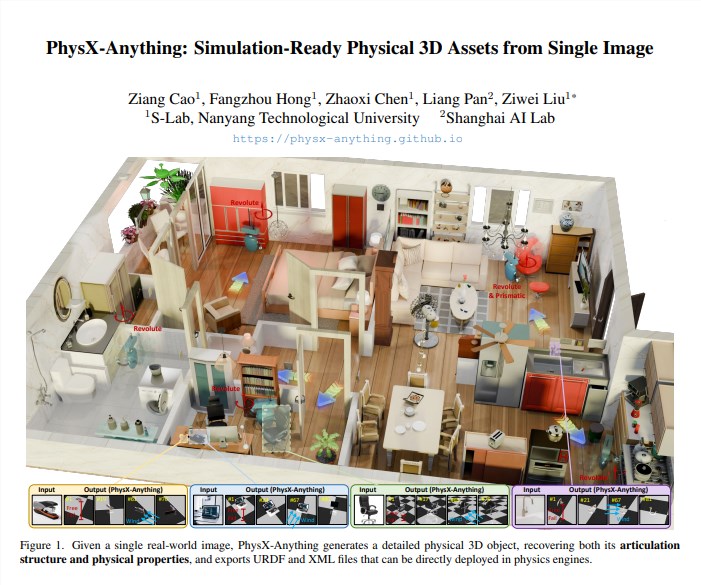

南洋理工大学と上海人工知能実験室は、オープンソースフレームワーク「PhysX-Anything」を発表しました。このフレームワークは、RGB画像1枚だけで、幾何学的構造や関節、物理パラメータを備えた3Dアセットを出力し、MuJoCoやIsaac Simに直接インポートしてロボットの戦略訓練を行うことができます。

技術の特徴

1. 俯瞰から詳細へのパイプライン:全体的な物理特性(質量、重心、摩擦係数)を予測した後、部品レベルで幾何形状と関節の極限角度を細かく調整することで、「視覚優先」による物理的誤差を回避します。

2. 新たな圧縮3D表現:ポリゴン+関節軸+物理特性を8K次元の隠れベクトルに符号化し、推論時に一度デコードすることで、生成速度がSOTAより2.3倍向上します。

3. 明示的な物理監督:データセットに12万組の実際の物理測定データを追加し、トレーニング段階で重心、慣性モーメント、衝突ボックスの損失関数を導入して、シミュレーションの一貫性を確保します。

実験結果

Geometry-ChamferとPhysics-Errorという2つの指標において、PhysX-Anythingはそれぞれ18%と27%低下しました。絶対スケール誤差は2cm未満、関節運動範囲の誤差は5度未満であり、ObjPhyやPhySGなどの最新手法よりも顕著に優れています。実際のシーンテスト(IKEAの家具や台所用品)では、生成されたアセットをIsaac Simにインポートした後、ロボットの掴み成功率が12%向上し、トレーニングステップ数が30%減少しました。

オープンソースと影響

プロジェクトはGitHubに公開され、モデル重み、データ、評価基準も同時に公開しています。チームは2026年第1四半期に「動画入力」をサポートするV2バージョンをリリースする予定で、可動部品の時系列トラジェクトリを予測でき、動的シナリオの戦略学習を支援します。

論文:https://arxiv.org/pdf/2511.13648