Meta 的人工智能研究團隊與新加坡國立大學合作開發了一種名爲 “自我對弈環境中的自我提升”(SPICE)的新型強化學習框架。該框架通過讓兩個 AI 代理相互對抗,創造自我提升的挑戰,使其在沒有人類監督的情況下逐漸提高能力。目前,這一框架仍處於概念驗證階段,但有望爲未來能夠動態適應環境的 AI 系統奠定基礎,從而在面對現實世界的不可預測性時更加穩健。

自我提升 AI 的目標是讓系統通過與環境的互動來增強自身能力。傳統方法通常依賴於人類策劃的問題集和獎勵機制,這使得擴展變得困難。而自我對弈的方式讓模型通過相互競爭來實現提升。然而,現有自我對弈方法在語言模型上的應用受到一些限制,如生成問題和答案中的事實錯誤相互疊加,導致 “幻覺” 現象。此外,當問題生成者和解答者共享相同知識庫時,無法生成新挑戰,容易陷入重複模式。

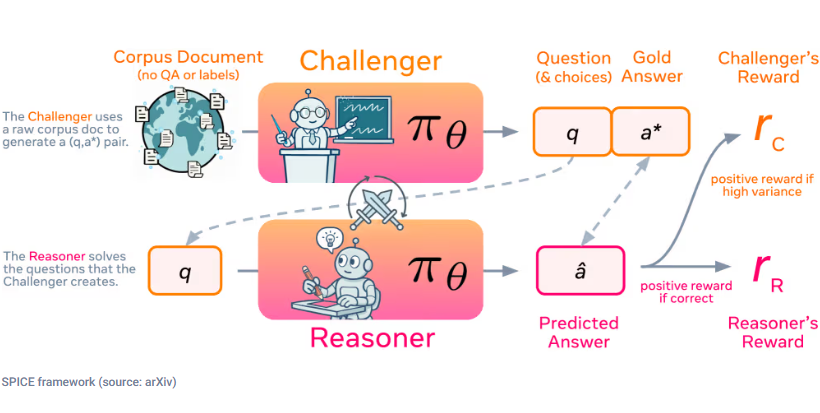

SPICE 框架採用一種創新的自我對弈機制,其中一個模型承擔兩個角色:“挑戰者” 構建來自大量文檔的困難問題,而 “推理者” 則嘗試在沒有訪問源文檔的情況下解決這些問題。這種設置打破了信息對稱,使得推理者無法使用挑戰者用來生成問題的知識,進而減少錯誤的發生。

這種對抗性動態創造了一個自動化的課程,挑戰者會因生成多樣且恰好位於推理者能力邊界的難題而獲獎,而推理者則因正確回答而獲獎。這種互惠的互動促進了兩個角色的共同成長,推動他們不斷髮現並克服新的挑戰。由於該系統利用的是原始文檔,而非預定義的問題 - 答案對,因而可以生成多種任務格式,適用於不同領域,打破了以往方法在特定領域的侷限。

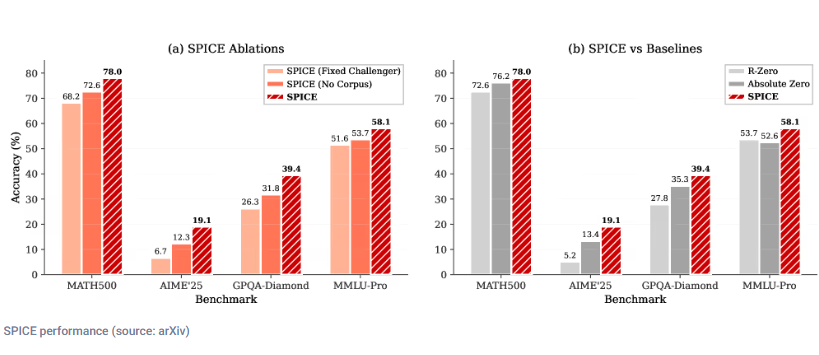

研究人員對多個基礎模型進行評估,發現 SPICE 在數學和一般推理任務中表現出色,超過了其他基線模型。這一發現表明,通過基於語料庫的自我對弈所培養的推理能力能夠有效遷移到不同模型上,預示着自我提升推理方法的新時代。

論文:https://arxiv.org/abs/2510.24684

劃重點:

✅ SPICE 框架通過自我對弈,讓 AI 系統在無監督情況下逐漸提升推理能力。

✅ 挑戰者與推理者角色分離,打破信息對稱,減少錯誤發生。

✅ SPICE 在多個模型測試中表現優異,展示了其廣泛的適用性和有效性。