近日,谷歌宣佈推出一款名爲 “gemma-2-2b-jpn-it” 的新模型,這是其 Gemma 系列語言模型的最新成員。這個模型專門針對日本語言進行優化,展示了谷歌在大型語言模型(LLM)領域持續投入的決心。

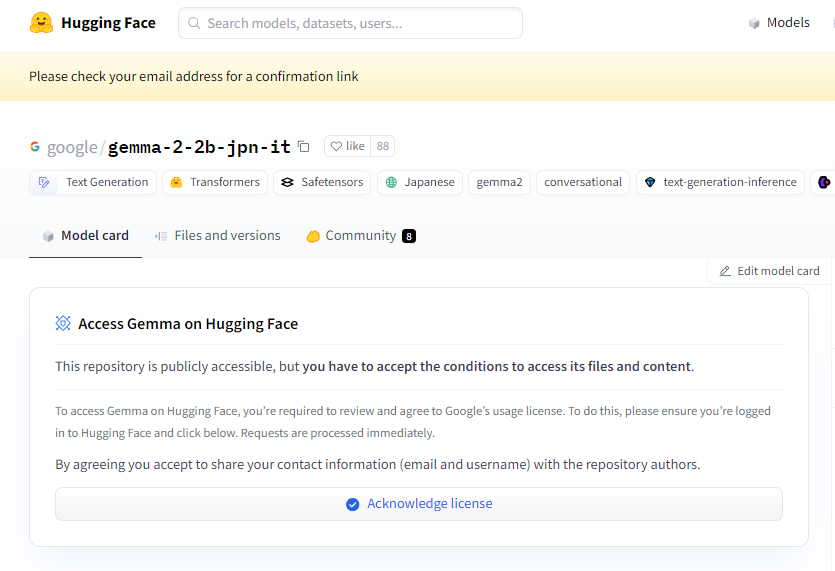

項目入口:https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it 是一款文本到文本的解碼器型大語言模型,具有開放權重,意味着它可以被公衆訪問,並能夠根據不同的文本生成任務進行細緻調優,比如問答、總結和推理等。

這款新模型擁有26.1億個參數,並採用 BF16張量類型。它基於谷歌的 Gemini 系列模型架構而設計,具備了非常先進的技術文檔和資源,開發者可以輕鬆使用推理將其集成到各種應用中。值得提的是,這款模型兼容谷歌最新的 TPU 硬件,特別是 TPUv5p。這種硬件提供了強大的計算能力,使得模型的訓練速度更快、性能更好,遠超傳統的 CPU 基礎設施。

在軟件方面,gemma-2-2b-jpn-it 使用 JAX 和 ML Pathways 框架進行訓練。JAX 經過特別優化,適合高性能機器學習應用,而 ML Pathways 則提供了靈活的平臺來組織整個訓練流程。這樣的結合使得谷歌能夠實現高效的訓練工作流程。

隨着 gemma-2-2b-jpn-it 的發佈,它在多個領域的應用潛力得到了廣泛關注。這款模型能夠在內容創作和溝通方面大顯身手,比如生成詩歌、劇本、代碼、營銷文案,甚至是聊天機器人回覆。它的文本生成能力同樣適用於摘要任務,可以將大量文本濃縮成簡明的摘要,非常適合用於研究、教育和知識探索。

然而,gemma-2-2b-jpn-it 也有一些侷限性,用戶需要了解。模型的表現依賴於其訓練數據的多樣性和質量,如果數據中存在偏差或缺失,可能會影響模型的迴應。此外,由於大型語言模型並不內置知識庫,在處理複雜查詢時,可能會生成不準確或過時的事實陳述。

在開發過程中,谷歌也十分重視倫理考量,對 gemma-2-2b-jpn-it 進行了嚴格的評估,以應對與內容安全、代表性損害以及訓練數據記憶相關的問題。谷歌還實施了過濾技術,以排除有害內容,並建立了透明和問責框架,鼓勵開發者持續監控並採用隱私保護技術確保遵守數據隱私法規。

劃重點:

🌟 谷歌推出的 gemma-2-2b-jpn-it 模型專爲日本語言優化,具備26.1億參數和先進的技術架構。

💡 該模型在內容創作、自然語言處理等領域具有廣泛應用潛力,支持多種文本生成任務。

🔒 谷歌在模型開發中重視倫理考量,實施內容安全過濾和隱私保護措施,以減少風險。