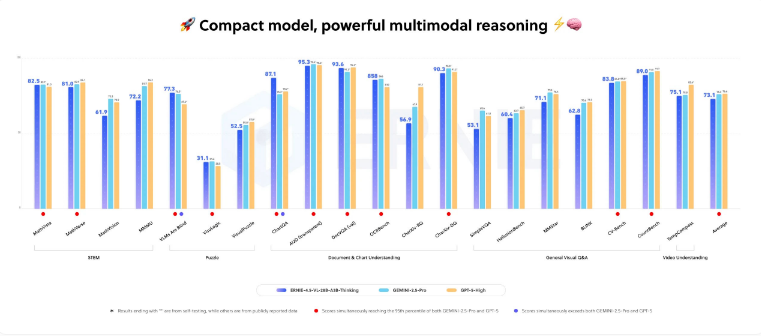

百度近日推出了其最新的多模態人工智能模型——ERNIE-4.5-VL-28B-A3B-Thinking,這是一款能夠將圖像深度整合到推理過程中的新型AI模型。百度聲稱,這款模型在多項多模態基準測試中表現出色,偶爾超越了包括谷歌的Gemini2.5Pro和OpenAI的GPT-5High在內的頂尖商業模型。

輕量級與高性能的結合

儘管該模型總參數量爲280億,但由於採用了路由架構,它僅使用了30億個活躍參數進行推理。憑藉這種高效的架構,ERNIE-4.5-VL-28B-A3B-Thinking 可以在單個配備80GB GPU(例如Nvidia A100)的設備上運行。百度已通過Apache2.0許可證發佈該模型,允許其免費用於商業項目。不過,百度所宣稱的性能尚未經過獨立驗證。

核心能力:“圖像思維”與精確定位

該模型的突出特性在於其**“圖像思維”(Image Thinking)**功能,使其能夠在推理過程中動態處理圖像,以突出關鍵細節。例如,該模型可以自動放大圖像中的藍色標誌並準確識別出上面的文字,相當於在內部使用了圖像編輯工具進行處理。

其他測試顯示了其強大的多模態能力:

能夠精確定位圖像中的人物並返回其座標。

通過分析電路圖解決複雜的數學問題。

根據圖表數據推薦最佳遊覽時間。

對於視頻輸入,能夠提取字幕並將場景與特定時間戳匹配。

可以訪問外部工具,例如基於網絡的圖像搜索,以識別陌生物體。

行業背景與功能對比

儘管百度強調了 ERNIE-4.5-VL-28B-A3B-Thinking 在推理過程中能夠裁剪和處理圖像,但這種方法並非全新。早在2025年4月,OpenAI就已在其o3和o4-mini模型中推出了類似功能,允許模型將圖像直接整合到內部思維流程中,並在處理視覺任務時使用縮放、裁剪和旋轉等原生工具,爲類智能體的推理和問題解決能力樹立了新的標杆。