在一個由數據和算法主導的數字世界裏,人工智能的每一步成長都離不開一個關鍵元素——檢查點(Checkpoint)。想象一下,當你正在訓練一個能讀懂人心、對答如流的大型語言模型時,這個模型聰明絕頂,但也是個"大胃王",需要海量計算資源來"餵飽"它。在訓練過程中,如果突然斷電或硬件故障,損失將是巨大的。這時,檢查點就像一臺"時光機",能讓一切回到上一個安全狀態,繼續未完成的任務。

然而,這臺"時光機"本身也需要精心設計。來自字節跳動和香港大學的科學家們,在論文《ByteCheckpoint: A Unified Checkpointing System for LLM Development》中,爲我們帶來了一種全新的檢查點系統——ByteCheckpoint。它不僅是一個簡單的備份工具,更是一個能大幅提升大型語言模型訓練效率的神器。

首先,我們需要了解大型語言模型(LLM)面臨的挑戰。這些模型之所以"大",是因爲它們需要處理和記憶海量信息,這帶來了高訓練成本、資源消耗大、容錯能力弱等問題。一旦發生故障,可能會導致長時間的訓練功虧一簣。

檢查點系統就像模型的"快照",在訓練過程中定期保存狀態,這樣即使出現問題,也能快速恢復到最近的狀態,減少損失。然而,現有的檢查點系統在處理大型模型時,常因I/O(輸入/輸出)瓶頸導致效率低下。

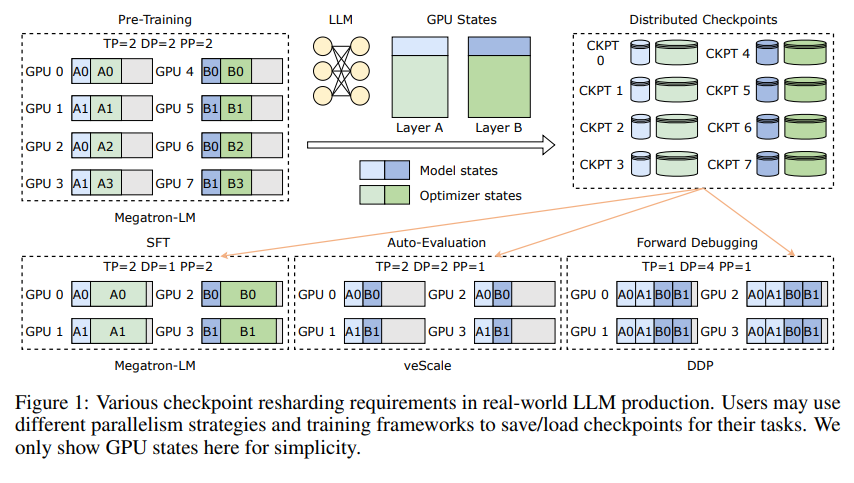

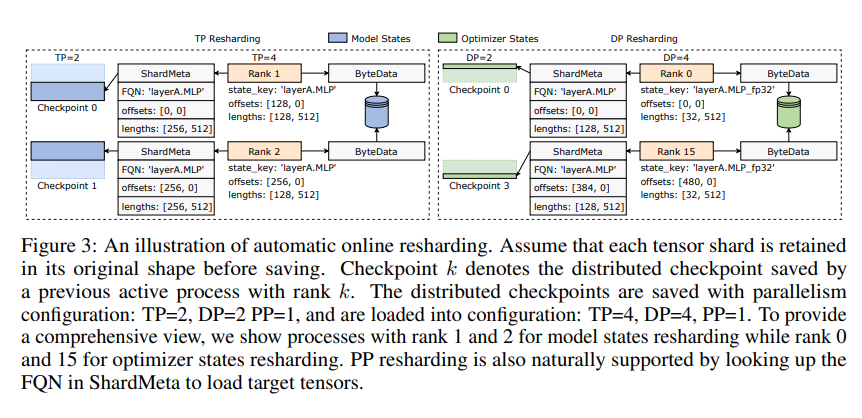

ByteCheckpoint的創新之處在於採用了一種新穎的存儲架構,將數據和元數據分離,更靈活地處理不同並行配置和訓練框架下的檢查點。更妙的是,它支持自動在線檢查點重分片,可在不中斷訓練的情況下,動態調整檢查點以適應不同硬件環境。

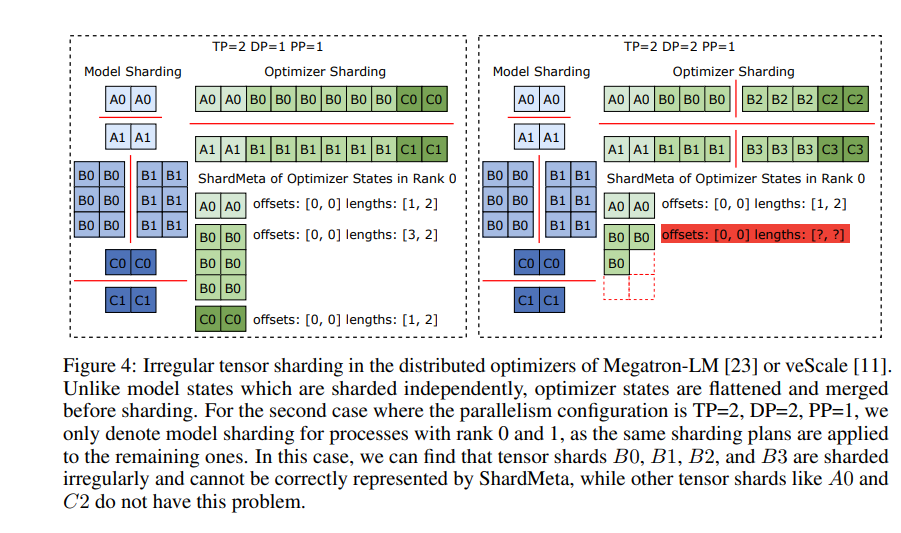

ByteCheckpoint還引入了一項關鍵技術——異步張量合併。這能高效處理那些在不同GPU上分佈不均的張量,確保在檢查點重分片時,模型的完整性和一致性不會受影響。

爲了提升檢查點保存和加載的速度,ByteCheckpoint還集成了一系列I/O性能優化措施,如精細的保存/加載流水線、Ping-Pong內存池、工作負載平衡保存和零冗餘加載等,大大減少了訓練過程中的等待時間。

通過實驗驗證,與傳統方法相比,ByteCheckpoint在檢查點保存和加載上的速度分別提高了數十倍甚至數百倍,顯著提升了大型語言模型的訓練效率。

ByteCheckpoint不僅是一個檢查點系統,更是大型語言模型訓練過程中的得力助手,是通往更高效、更穩定AI訓練之路的關鍵所在。

論文地址:https://arxiv.org/pdf/2407.20143