最近、モールス・スレッドのAI研究チームは、国際的な頂級学術会議AAAI2026で最新の研究成果を発表し、URPO(統一報酬とポリシー最適化)という革新フレームワークを提案しました。この技術は、大規模言語モデルのトレーニングプロセスを簡略化し、パフォーマンスのボトルネックを突破することを目的としており、AI分野に新たな技術的アプローチをもたらします。

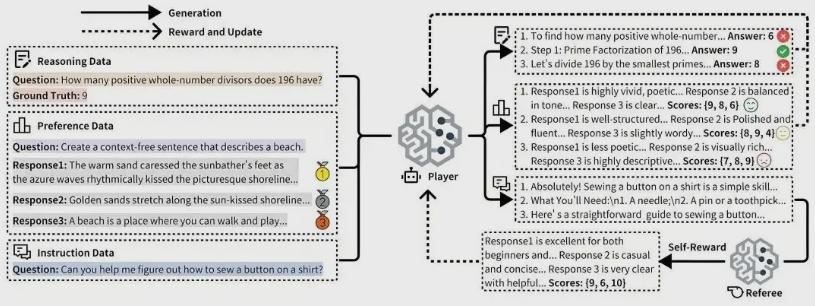

『URPO:A Unified Reward & Policy Optimization Framework for Large Language Models』というタイトルの論文において、研究チームは従来の「大モデルトレーニング」方法を再構築しました。URPOフレームワークの特徴は、「指示の理解」と「報酬の評価」の2つの役割を一つにまとめ、単一のモデルがトレーニング段階で同時に最適化できる点です。これは、モデルが指示を理解するだけでなく、自分自身でスコアリングができるようになり、トレーニングの効率と効果を向上させます。

URPOフレームワークは、3つの主要な技術において現在の課題を克服しました。第一に、データ形式の統一です。研究チームは、異なる種類のデータ(好みデータ、検証可能な推論データ、オープンエンド指令データ)をGRPOトレーニングに適した統一信号形式に変換することに成功しました。第二に、自己報酬ループにより、モデルは複数の候補回答を生成した後、自分でスコアリングを行い、その結果をGRPOトレーニングの報酬信号として使用することで、効率的な自己改善ループを形成できます。第三に、協調進化メカニズムによって、3種類のデータを混合処理し、モデルの生成能力と評価能力の両方を向上させました。

実験の結果、Qwen2.5-7Bモデルに基づくURPOフレームワークは、独立した報酬モデルに依存する従来のベースラインよりも多くの性能指標で優れています。例えば、AlpacaEval指令追従ランクでは44.84ポイントに達し、総合的推論能力テストの平均点は32.66から35.66に上昇しました。また、RewardBench報酬モデル評価では85.15ポイントを獲得し、専用報酬モデルの83.55ポイントを上回り、URPOの優位性を十分に示しています。

注目すべきは、モールス・スレッドが自社開発の計算カード上でURPOフレームワークの効率的な動作を実現し、主流の強化学習フレームワークVERLとの深く適合させたことです。この突破は、モールス・スレッドが大規模モデルトレーニング分野でのリーダーシップを示すものであり、今後のAI発展への方向性を示しています。