Maya Researchは最近、30億パラメータを持つテキストから音声への変換モデルであるMaya1をリリースしました。このモデルは、テキストと短い説明文をもとに制御可能で表現豊かな音声を生成でき、単一のGPUでリアルタイムに動作します。Maya1のコア機能は、本物の人間の感情を捉え、正確な音声デザインを行うことです。

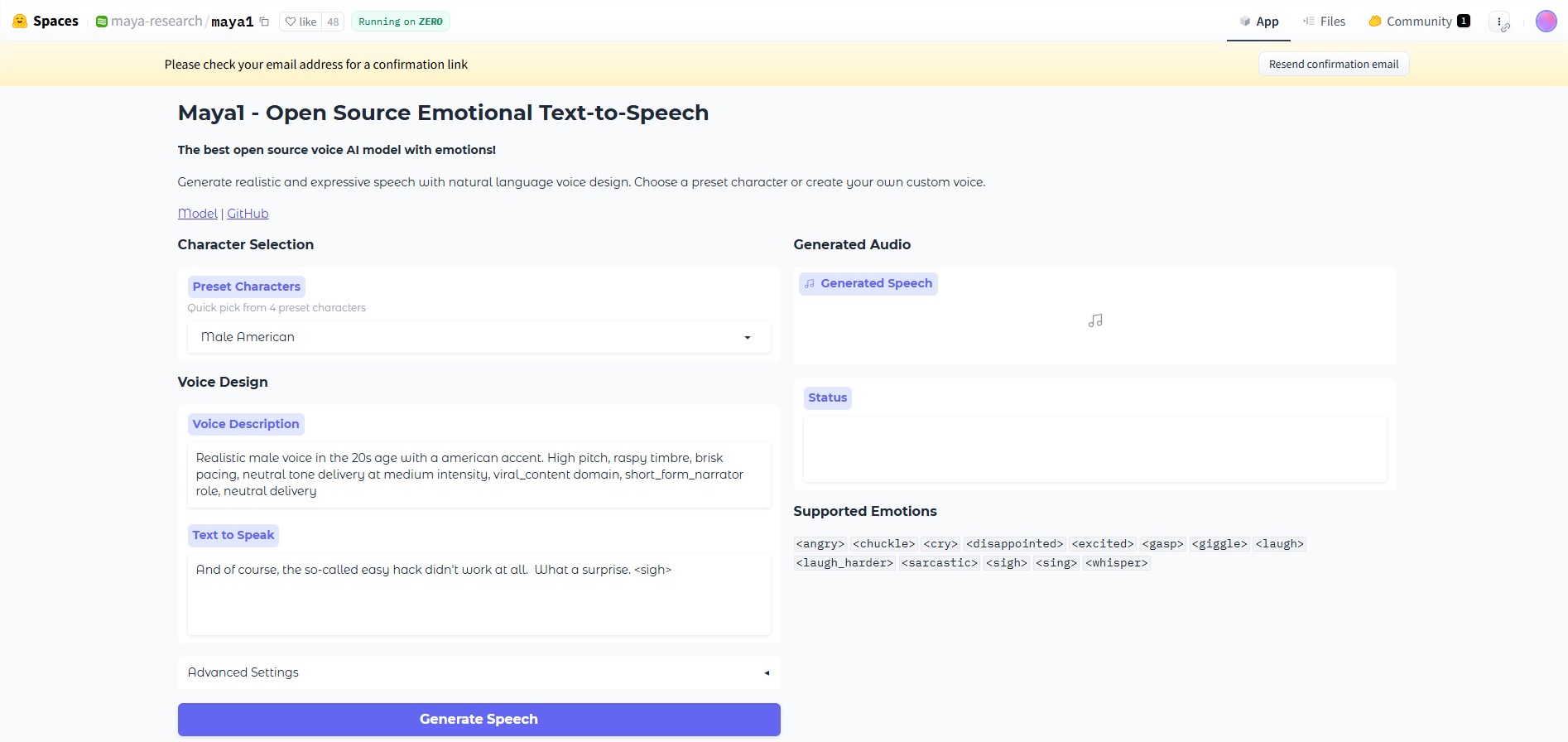

Maya1の操作インターフェースには2つの入力があります:自然言語による音声の説明と読み上げたいテキストです。例えば、ユーザーは「20代の女性、イギリス訛り、元気いっぱい、明確な発音」や「悪魔のキャラクター、男性の声、低音、かすれたトーン、ゆっくりとしたテンポ」と入力できます。モデルはこれらの2つの信号を組み合わせて、内容と説明スタイルに合った音声を生成します。また、ユーザーはテキストに感情タグを挿入することができ、たとえば<笑>、<ため息>、<ささやき>など、20種類以上の感情が選べます。

Maya1が出力する音声は24kHzのモノラルであり、リアルタイムストリーミングをサポートしているため、アシスタント、インタラクティブエージェント、ゲーム、パーソナライズドポッドキャストやライブ配信コンテンツに非常に適しています。Maya Researchチームは、このモデルの性能が多くのトップクラスの専用システムを上回っていると主張しており、完全にオープンソースで、Apache2.0ライセンスに従っています。

アーキテクチャにおいて、Maya1はデコーダーのみの変換器であり、Llamaに似た構造を持っています。このモデルは直接原始波形を予測せず、SNACと呼ばれる神経音声エンコーダーによってエンコードを予測します。全体的な生成プロセスにはテキスト処理、エンコード生成、および音声デコードが含まれており、これにより生成効率が向上し、拡張性も向上しています。

Maya1のトレーニングデータは、インターネット規模の英語音声コーパスから取得され、広範囲な音響カバー範囲と自然な一貫性を学ぶことを目的としています。その後、人間によって検証された音声説明と多様な感情タグを含む厳選された専有データセット上で微調整が行われました。

単一のGPUで推論および展開を行うために、Maya1は16GB以上のVRAMを持つカード、例えばA100、H100またはRTX4090を推奨しています。さらに、Maya Researchチームは、リアルタイム音声生成およびストリーミングサポートを容易にするためのツールとスクリプトを提供しています。

huggingface:https://huggingface.co/spaces/maya-research/maya1

ポイント:

🎤 Maya1は、30億パラメータを持つオープンソースのテキストから音声への変換モデルで、表現豊かな音声をリアルタイムで生成できます。

💡 このモデルは自然言語の説明とテキスト入力を組み合わせ、さまざまな感情タグをサポートし、音声の表現力を高めます。

🚀 Maya1は単一のGPUで動作でき、効率的な推論と展開をサポートするさまざまなツールを提供します。