最近、OpenAI は新しい軽量モデルである GPT-5Codex Mini を正式リリースしました。このモデルは、より効率的でコストが低いコード生成能力を提供することを専門としており、開発者により柔軟な選択肢を提供することを目的としています。同時に、OpenAI は Codex の使用枠を拡大し、既存のサブスクリプションプランやポイントシステム内でより多くの呼び出し回数を取得できるようにしました。

サービスレベルの調整に関しては、OpenAI も大きな変化をもたらしています。ChatGPT Plus、Business、Edu ユーザー向けには、レート制限が約50%向上し、これによりユーザーがリクエストを処理する際にはよりスムーズなサービス体験が可能になります。一方、ChatGPT Pro および Enterprise ユーザーには優先処理の特典があり、応答時間をさらに短縮し、重要な瞬間に問題が生じないよう確保されます。

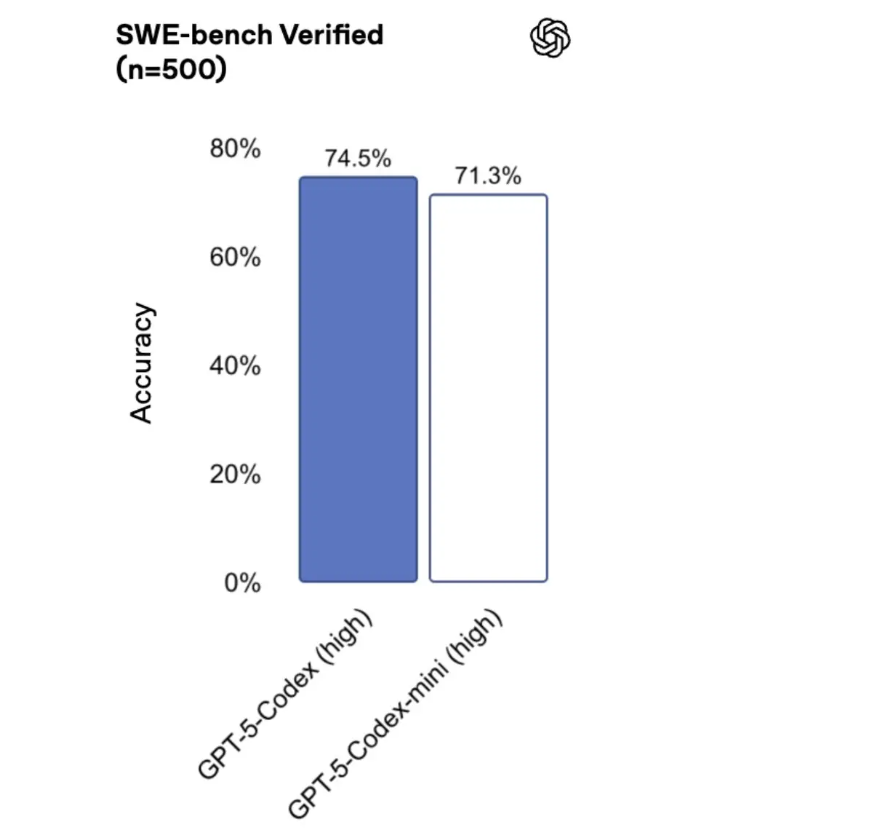

OpenAI はまた、単純なソフトウェアエンジニアリングタスクを処理する場合や、呼び出し制限に近づいている場合、新しくリリースされた GPT-5Codex Mini モデルを使用することを開発者に推奨しています。ユーザーの呼び出し量が割当量の90%に近づくと、Codex はこの新しいモデルへの切り替えをスマートに推奨します。GPT-5Codex Mini は現在、コマンドラインインターフェース(CLI)と統合開発環境(IDE)の拡張をサポートしており、API インターフェースも間もなく公開される予定です。

今回のアップデートでは、OpenAI チームが Codex の下層構造を最適化し、開発者が使用する際の体験を一貫性のあるものにしています。以前のバージョンでは、実際の呼び出し量がトラフィック負荷やルーティング配分の影響で変動することがありました。しかし、今回の最適化により、この問題は効果的に解決され、一日の作業中に安定したサービス体験を保つことができます。

OpenAI のこれらのアップデートにより、開発者にはより多くの選択肢と効率的な作業方法が提供され、AI がプログラミング分野での応用をさらに促進することになります。