在多模態人工智能領域,智源研究院與多所高校合作推出了全新的多模態向量模型 BGE-VL,標誌着多模態檢索技術的一次重大突破。自發布以來,BGE 系列模型便獲得了廣泛讚譽,而 BGE-VL 的推出則進一步豐富了這一生態系統。該模型在圖文檢索、組合圖像檢索等多項關鍵任務中表現出色,展現出其卓越的性能。

BGE-VL 的成功歸功於其背後的 MegaPairs 數據合成技術。這一創新方法通過挖掘現有的大規模圖文數據,自動生成高質量的多模態三元組數據,顯著提升了數據的可擴展性和質量。MegaPairs 能夠以極低的成本生成多樣化的數據集,其包含超過2600萬條樣本,爲多模態檢索模型的訓練提供了豐厚的基礎。這一技術讓 BGE-VL 在多個主流多模態檢索基準上都取得了領先成績。

在多模態檢索日益受到重視的今天,用戶對信息的獲取需求愈發多樣化。以往的檢索模型多依賴於單一的圖文對進行訓練,無法有效應對複雜的組合輸入。而 BGE-VL 通過引入 MegaPairs 數據,克服了這一侷限,使得模型能夠更全面地理解和處理多模態查詢。

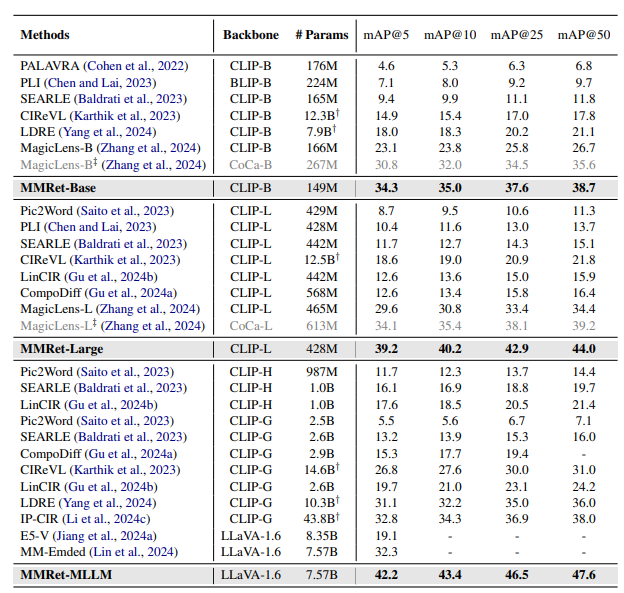

智源團隊在多個任務的性能評測中,發現 BGE-VL 模型在 Massive Multimodal Embedding Benchmark(MMEB)上的零樣本性能表現優異,儘管 MegaPairs 未涵蓋 MMEB 中的大部分任務,但其任務泛化能力依然令人振奮。此外,在組合圖像檢索的評測中,BGE-VL 同樣表現突出,大幅超過了衆多知名模型,如谷歌的 MagicLens 和英偉達的 MM-Embed。

未來,智源研究院計劃繼續深化 MegaPairs 技術,結合更豐富的多模態檢索場景,致力於打造更加全面和高效的多模態檢索器,爲用戶提供更爲精準的信息服務。隨着多模態技術的發展,BGE-VL 的推出無疑將推動相關領域的進一步探索與創新。

論文地址:https://arxiv.org/abs/2412.14475

項目主頁:https://github.com/VectorSpaceLab/MegaPairs

模型地址:https://huggingface.co/BAAI/BGE-VL-MLLM-S1