在人工智能(AI)技術快速發展的今天,DeepSeek 團隊推出了其全新的 DeepSeek-V3/R1推理系統。這一系統旨在通過更高的吞吐量和更低的延遲,推動 AGI(通用人工智能)的高效發展。爲了實現這一目標,DeepSeek 採用了跨節點專家並行(Expert Parallelism,EP)技術,顯著提高了 GPU 的計算效率,並在降低延遲的同時,擴展了批處理規模。

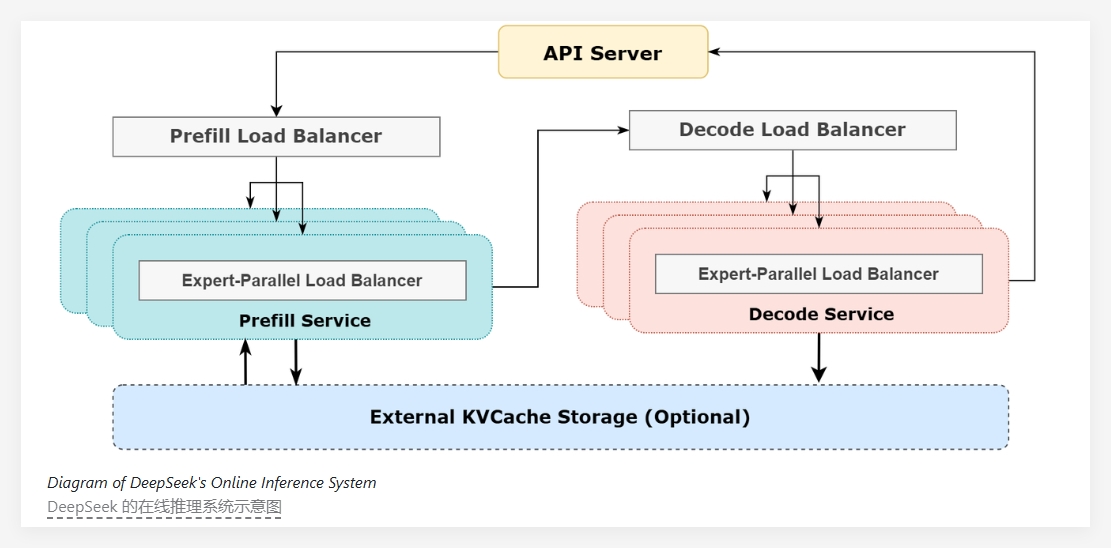

DeepSeek-V3/R1的核心在於其極高的稀疏性,模型中每層僅激活256個專家中的8個,因此需要非常大的批處理大小,以確保每個專家都有足夠的處理能力。該系統的架構採用了預填充解碼解聚(prefill-decode disaggregation)的方法,在預填充和解碼階段採用不同程度的並行化策略。

在預填充階段,系統通過雙批次重疊策略來隱藏通信成本,這意味着在處理一批請求時,另一批的通信成本可以被計算過程所掩蓋,從而提升了整體吞吐量。而在解碼階段,針對不同執行階段的時間不平衡問題,DeepSeek 採用了五級流水線的方式,實現了無縫的通信與計算重疊。

爲了應對大規模並行性所帶來的負載不均問題,DeepSeek 團隊設立了多個負載均衡器。這些負載均衡器致力於在所有 GPU 之間平衡計算和通信負載,避免某一單一 GPU 因超負荷運算而成爲性能瓶頸,確保資源的高效利用。

在服務性能方面,DeepSeek-V3/R1推理服務在 H800GPU 上運行,使用的矩陣乘法和傳輸格式與訓練過程保持一致。根據最新的統計數據,系統在過去24小時內處理了6080億個輸入令牌,最高節點佔用率達278,日均佔用率爲226.75,整體服務表現良好。

DeepSeek-V3/R1推理系統通過高效的架構設計和智能的負載管理,不僅提升了人工智能模型的推理性能,也爲未來的 AGI 研究與應用提供了強有力的基礎設施支持。

項目:https://github.com/deepseek-ai/open-infra-index/blob/main/202502OpenSourceWeek/day_6_one_more_thing_deepseekV3R1_inference_system_overview.md

劃重點:

🌟 DeepSeek-V3/R1推理系統通過跨節點專家並行技術,實現更高的吞吐量和更低的延遲。

📊 採用雙批次重疊策略與五級流水線,提升計算效率並優化通信過程。

🔄 設立多種負載均衡器,確保 GPU 間的資源高效利用,避免性能瓶頸。