在自然語言處理領域,大型語言模型(LLMs)的發展迅速,已經在多個領域取得了顯著的進展。不過,隨着模型的複雜性增加,如何準確評估它們的輸出就變得至關重要。傳統上,我們依賴人類來進行評估,但這種方式既耗時又難以規模化,無法跟上模型快速發展的步伐。

爲了改變這種現狀,Salesforce AI 研究團隊推出了 SFR-Judge,這是一個由三個大型語言模型組成的評估家族。這些模型分別擁有80億、120億和700億個參數,基於 Meta Llama3和 Mistral NeMO 構建。SFR-Judge 能夠執行多種評估任務,包括成對比較、單一評分和二分類評估,旨在幫助研究團隊快速高效地評估新模型的表現。

傳統的 LLM 評估模型往往存在一些偏差問題,比如位置偏差和長度偏差,這會影響它們的判斷。爲了克服這些問題,SFR-Judge 採用了直接偏好優化(DPO)訓練方法,讓模型從正負例中學習,從而提升其評估任務的理解能力,減少偏差,確保判斷的一致性。

在測試中,SFR-Judge 在13個基準測試上表現優異,超過了許多現有的評估模型,包括一些私有模型。特別是在 RewardBench 排行榜上,SFR-Judge 的準確率達到了92.7%,這是生成型評估模型首次和第二次超越90% 的門檻,展現出其在評估模型中的卓越表現。

SFR-Judge 的訓練方法涵蓋三種不同的數據格式。首先是 “思維鏈批評”,幫助模型生成對評估響應的結構化分析。其次是 “標準評判”,簡化評估過程,直接反饋響應是否符合標準。最後,“響應推導” 則幫助模型理解高質量回應的特徵,強化其判斷能力。這三種數據格式的結合,使得 SFR-Judge 的評估能力得到了極大提升。

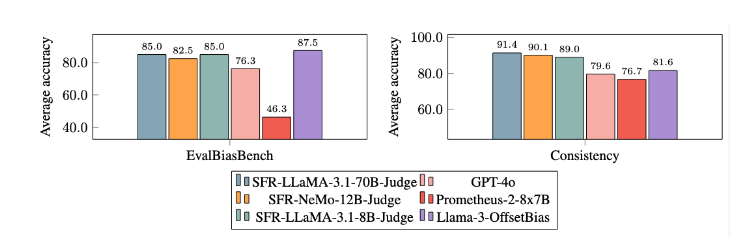

經過大量實驗,SFR-Judge 模型在減少偏差方面表現顯著優於其他模型。在 EvalBiasBench 基準測試中,它們展現了高度的成對順序一致性,這表明即便響應順序發生變化,模型的判斷依然保持穩定。這使得 SFR-Judge 成爲一種可靠的自動化評估解決方案,減少了對人工標註的依賴,爲模型評估提供了更可擴展的選擇。

論文入口:https://arxiv.org/abs/2409.14664

劃重點:

📊 高準確率:SFR-Judge 在13個基準測試中取得了10個最佳成績,尤其是在 RewardBench 上達到了92.7% 的高準確率。

🛡️ 偏差緩解:該模型顯示出比其他評估模型更低的偏差,特別是在長度和位置偏差方面。

🔧 多功能應用:SFR-Judge 支持成對比較、單一評分和二分類評估,能夠適應多種評估場景。