在這個信息爆炸的時代,我們每天都在用圖片和視頻記錄生活,分享快樂。但你有沒有想過,如果有一種技術,能夠讓機器像人類一樣,不僅能看懂這些圖片和視頻,還能和我們進行深入的交流,那會怎樣?

阿里團隊最新發布的通用多模態大模型mPLUG-Owl3,以其驚人的效率和理解能力,讓我們在4秒內就能"看"完一部2小時的電影!這不僅僅是一個模型,更像是一個能看、能聽、能說、能思考的AI助手。

mPLUG-Owl3,這個名字聽起來就像是一隻戴着眼鏡的貓頭鷹,聰明而機警。它的核心能力,就是對長圖像序列的理解。不管是一連串的照片,還是一段視頻,它都能看懂裏面的內容,甚至能夠理解其中的故事線。

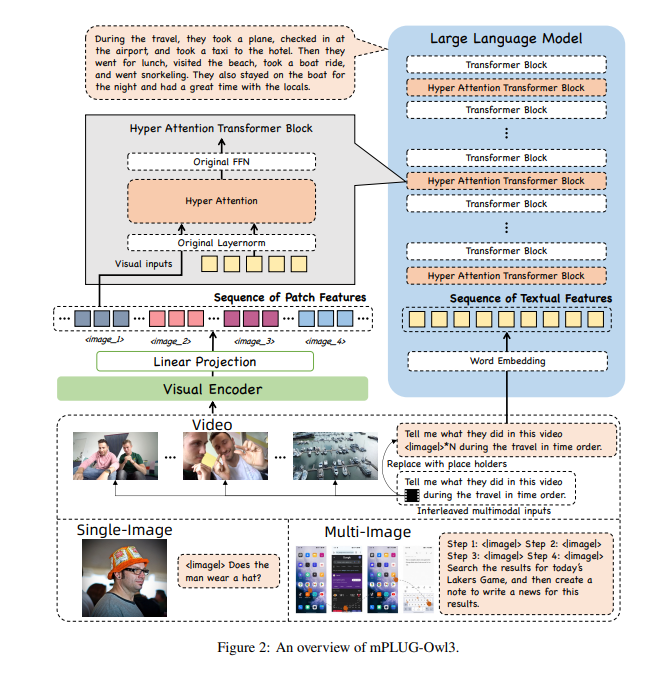

爲了讓mPLUG-Owl3能夠處理這麼多信息,研究者們給它裝上了一個超級大腦——超注意力模塊。這個模塊就像是AI的超級大腦,能夠同時處理視覺和語言信息,讓AI在理解圖像的同時,還能夠理解與之相關的文本信息。

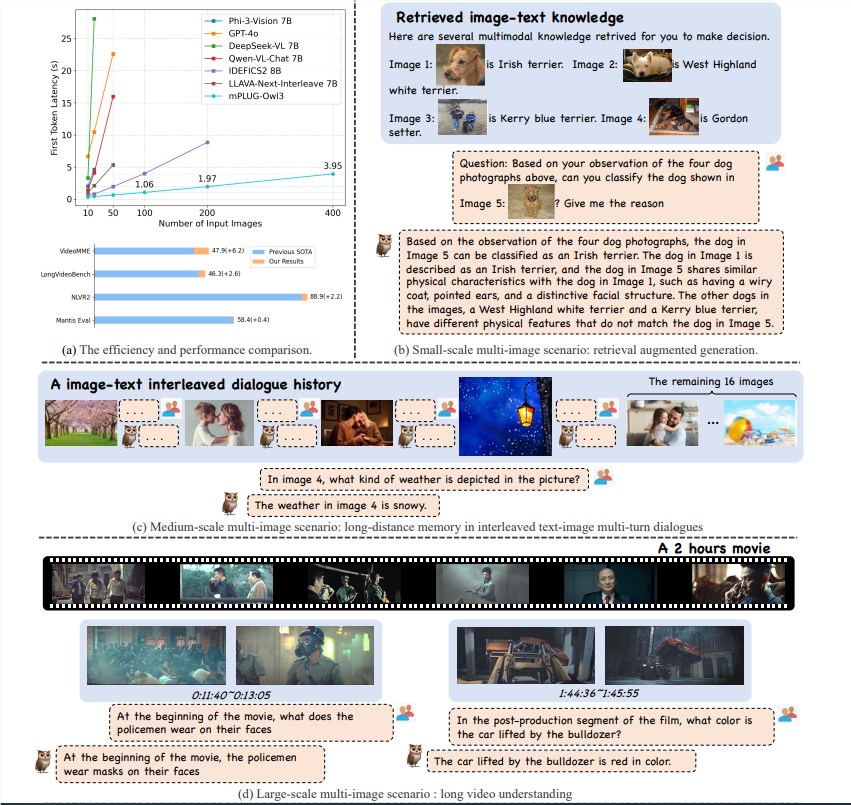

mPLUG-Owl3模型以其卓越的推理效率,在多模態理解領域取得了重大突破。它不僅在單圖、多圖、視頻等多場景Benchmarks上達到了SOTA(State of the Art),而且First Token Latency縮小了6倍,單張A100顯卡能處理的圖像數目提升了8倍,達到了400張。

mPLUG-Owl3能夠準確理解傳入的多模態知識,並用於解答問題。它甚至能告訴你它是根據哪一條知識做出的判斷,以及詳細的判斷依據。

mPLUG-Owl3能夠正確理解不同材料中的內容關係,進行深入推理。無論是風格差異還是角色識別,它都能輕鬆應對。

mPLUG-Owl3能夠觀看並理解長達2小時的視頻,4秒內就能開始回答用戶的問題,無論問題涉及視頻的哪個部分。

mPLUG-Owl3採用了輕量化的Hyper Attention模塊,將Transformer Block擴展成能夠進行圖文特徵交互和文本建模的新模塊。這種設計大幅度降低了額外引入的新參數,使得模型更容易訓練,並且訓練和推理效率也得到了提升。

在廣泛的數據集上進行實驗,mPLUG-Owl3在大多數單圖多模態Benchmarks上都取得了SOTA效果。在多圖測評中,它超越了專門針對多圖場景優化的模型。在LongVideoBench上,它更是超越了現有模型,顯示出其在長視頻理解方面的卓越能力。

阿里mPLUG-Owl3的發佈,不僅是技術上的一次飛躍,更爲多模態大模型的應用提供了新的可能性。隨着技術的不斷完善,我們期待mPLUG-Owl3在未來能夠帶來更多驚喜。

論文地址:https://arxiv.org/pdf/2408.04840

代碼:https://github.com/X-PLUG/mPLUG-Owl/tree/main/mPLUG-Owl3

在線體驗:https://huggingface.co/spaces/mPLUG/mPLUG-Owl3