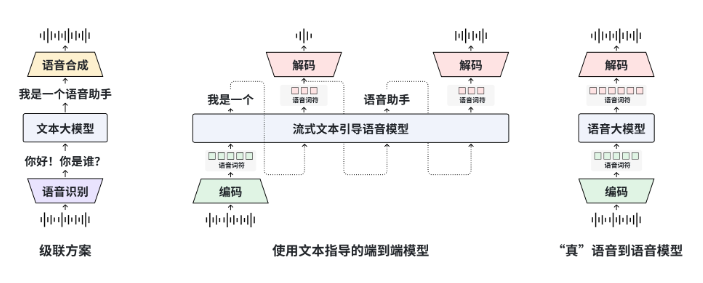

復旦大学のMOSSチームは、MOSS-Speechをリリースしました。これは最初にエンド・トゥ・エンドのSpeech-to-Speech対話を実現したモデルであり、Hugging Face Demoにアップロードされ、同時にオープンソースの重みとコードも公開されています。MOSS-Speechは「レイヤー分割」アーキテクチャを採用しています。元のMOSSテキスト大規模モデルのパラメータを凍結し、新たに音声理解、意味の一致、ニューラルボイサーの3層を追加しています。これにより、一度に音声質問応答、感情の模倣、笑いの生成が可能です。ASR→LLM→TTSの3段階のフローは不要です。

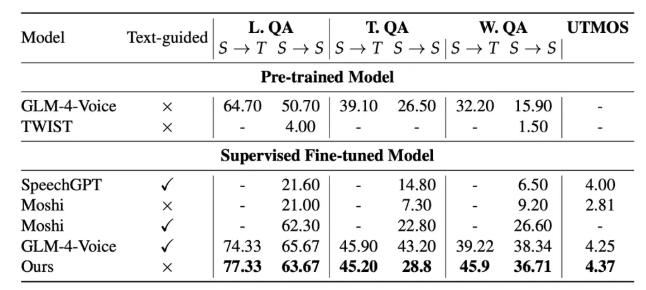

評価結果によると、MOSS-SpeechはZeroSpeech2025の無文脈音声タスクにおいてWERを4.1%まで低下させ、感情認識の正確率は91.2%で、MetaのSpeechGPTやGoogleのAudioLMよりも優れています。中国語の会話テストでは主観的なMOSスコアが4.6で、人間の録音の4.8に近づいています。プロジェクトでは48kHzの超サンプリング版と16kHzの軽量版が提供されており、後者は単一のRTX4090でリアルタイム推論が可能で、遅延は300ms未満であり、モバイルデバイスへの導入に適しています。

チームは、次段階として「音声制御版」のMOSS-Speech-Ctrlを開源する予定で、音声指示により速度、声の質、感情の強度を動的に調整できるようになります。2026年Q1にリリース予定です。MOSS-Speechは商用利用許諾を開放しており、開発者はGitHubからトレーニングおよび微調整スクリプトを取得でき、ローカルでプライベートな声のクローン作成やキャラクターの音声化が可能です。