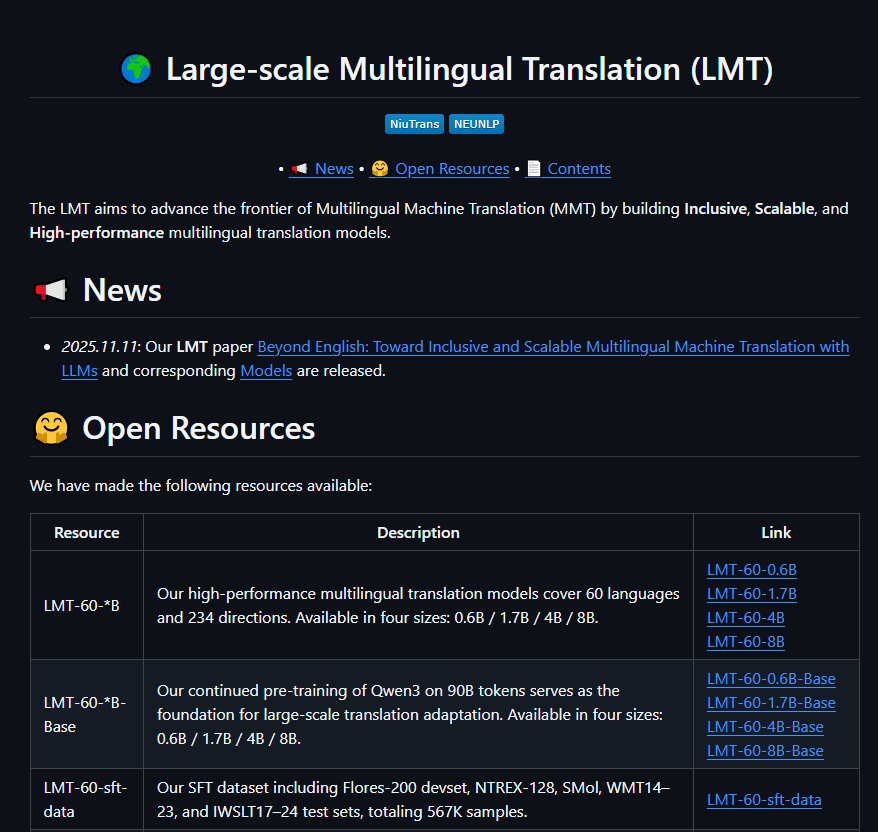

中国のAI翻訳技術が新たな高みに達しました。東北大学「小牛翻訳」チームは最近、最新の大規模モデルであるNiuTrans.LMT(Large-scale Multilingual Translation)を正式にオープンソース化しました。これにより、60言語、234の翻訳方向を完全にカバーし、中国語と英語を二つの中心として世界中の言語の橋渡しを実現しました。また、チベット語やアムハラ語などの29種類の低リソース言語においても大きな進展を遂げ、グローバルな言語の平等に向けて重要な一歩を踏み出しました。

二重センター構造で「英語支配」を打ち破る

多くの翻訳モデルが英語を唯一のハブとして使用するのとは異なり、NiuTrans.LMTは中国語-英語の二重センター設計を採用しています。これにより、中国語↔58言語、英語↔59言語の高品質な直接翻訳が可能となり、「中国語→英語→小語種」という二次的な情報損失を避けることができます。この構造は特に「一帯一路」沿線国と中国語使用者との直接的なコミュニケーションに有利であり、文化的な交流を中間者なしで促進します。

三段階の言語カバーで効率と公平性を両立

モデルは言語リソースのレベルを正確に分類しています:

13種類の高リソース言語(フランス語、アラビア語、スペイン語など):翻訳の流れが人間とほぼ同じ;

18種類の中リソース言語(ヒンディー語、フィンランド語など):専門用語や文法構造において高い正確さを維持;

29種類の低リソース言語(チベット語、スワヒリ語、ベンガル語など):データ増強と移動学習を通じて、「不可訳」から「使える訳」への飛躍を実現。

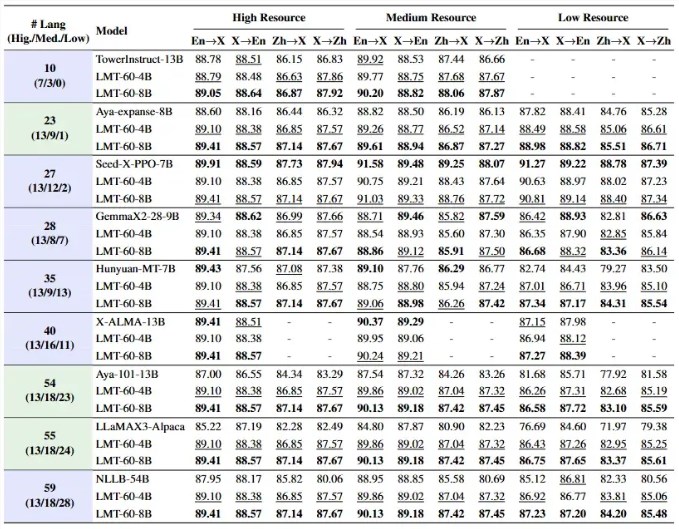

二段階トレーニングでFLORES-200でトップを獲得

NiuTrans.LMTは権威ある多言語ベンチマークFLORES-200で優れた成績を収め、オープンソースモデルの中でトップを維持しています。その成功は革新的な二段階トレーニングプロセスにあります:

継続的予訓練(CPT):900億トークン以上の多言語コーパス上でバランスよく学習し、小語種が埋もれないようにする;

監督的微調整(SFT):FLORES-200、WMTなどの高品質な並列コーパス(567,000サンプル、117方向をカバー)を統合し、翻訳の正確さとスタイルの一貫性を精査する。

四段階のオープンソースで研究開発から商用までカバー

さまざまなシナリオのニーズに対応するために、チームは0.6B、1.7B、4B、8Bの4つのパラメータサイズのモデルを同時にオープンソース化しました。すべてがGitHubとHugging Faceで無料ダウンロード可能です。軽量版はコンシューマー向けGPUで動作でき、モバイルデバイスでの導入に適しています。8Bバージョンは企業向けの高精度翻訳シナリオを対象とし、APIの統合とプライベート配備をサポートします。

AIbaseによると、NiuTrans.LMTの公開は単なる技術成果ではなく、「言語多様性の保護」に対する具体的な行動です。AIがチベット語の詩やアフリカの諺、ノルドの古語を正確に翻訳できるとき、技術は真に人間的な温かさを持ちます。東北大学のこのオープンソース取り組みは、世界中に言語の壁がないデジタル未来を築くための基盤を作っています。

プロジェクトアドレス:https://github.com/NiuTrans/LMT