テキスト生成や画像生成が大規模モデルによって大きく変化した時代において、音声編集はまだ「テキストのように直感的に操作できる」領域としては最も難しい分野の一つです。しかし最近、StepFun AIが公開した全新开発プロジェクト「Step-Audio-EditX」がこの状況を変えていこうとしています。このモデルは、30億パラメータの音声言語モデル(Audio LLM)を基盤としており、従来の波形信号処理タスクではなく、「テキストのタグレベルのような制御可能な操作」に音声編集を変換することに成功しています。

チームが最新論文 arXiv:2511.03601 で紹介したように、Step-Audio-EditX の目的は開発者が「1文を編集するように、直接音声の感情、トーン、スタイル、さらには息遣いを編集できるようにすること」です。

「音声を模倣する」から「正確な制御」へ

現在のほとんどのゼロサンプルTTSシステムは、短い参照音声から感情やアクセント、音色をコピーすることはできますが、自然に聞こえるものの制御力がありません。テキスト中のスタイルヒントはしばしば無視され、特に異言語や異スタイルのタスクでは効果が不安定です。

Step-Audio-EditXは完全に異なるアプローチを取っています。「複雑な分離エンコーダ構造」に依存せず、データ構造とトレーニング目標を変更することで制御性を実現しました。モデルは、テキストは同じだが属性が著しく異なる音声対や音声トリオを大量に学習し、テキストを変えずに感情、スタイル、副言語信号を調整する方法を学んでいます。

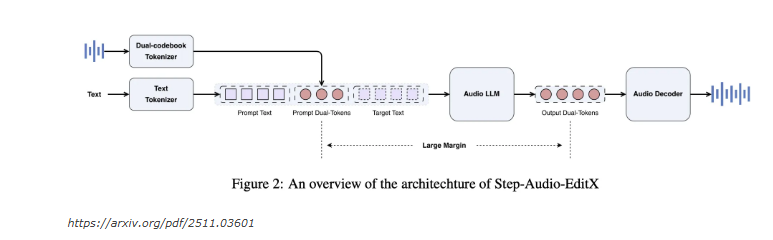

ダブルコードブックトークナイザと3Bの音声LLMアーキテクチャ

Step-Audio-EditXは、Step-Audioの「ダブルコードブックトークナイザ(Dual Codebook Tokenizer)」を引き継いでいます:

言語フロー: サンプリングレート16.7Hz、1024のトークン;

意味フロー: サンプリングレート25Hz、4096のトークン;

これらは2:3の比率で交互配置

この上で研究チームは、30億パラメータのコンパクトな音声LLMを構築しました。モデルはテキストLLMで初期化され、テキストと音声トークンの比率が1:1の混合語彙でトレーニングされています。これはテキストまたは音声トークンを読み取り、常に二重コードブックトークンシーケンスを出力します。

音声再構成は別途のデコーダーによって行われます。拡散変換器フローマッチングモジュールがメルスペクトログラムを予測し、BigVGANv2声碼器がそれを波形に変換します。このモジュールは20万時間の高品質音声でトレーニングされており、音色とリズムの自然さを大幅に向上させています。

大間隔学習と合成データ戦略

Step-Audio-EditXの重要な革新は「大間隔学習(Large Margin Learning)」です。モデルはテキストを変えることなく、三つ組みと四つ組みのサンプルを使って「差が明確な」音声属性間での変換を学びます。

チームは中国語、英語、広東語、四川語を含む6万人の話者データセットを使用し、感情とスタイルの制御を強化するために合成三つ組みを作成しました。各グループは人工声優によって10秒のセグメントを録音し、StepTTSシステムで中立版と感情版を生成し、人工とモデルによる両方のスコアリングで質の高いサンプルをフィルタリングしました。

副言語(笑い、呼吸、間の停頓など)の編集はNVSpeechデータセットに基づいており、クローニングとラベリングにより時域の監督を得て、追加のマージンモデルなしで実現されます。

SFT + PPO: モデルに指示を理解させる

トレーニングは2段階に分けられます:

教師あり微調整(SFT): モデルは統一されたチャット形式の中でTTSと編集タスクを同時に学習します;

強化学習(PPO): 奖励モデルを用いて自然言語の指示への応答を最適化します。

報酬モデルはSFTチェックポイントから初期化され、ブラッドリー・テリー損失を用いて大間隔の好み対でトレーニングされ、マークレベルで報酬を計算します。波形をデコードすることなく、PPOはKLペナルティ項を組み合わせて音質とバイアスのバランスを保ちます。

Step-Audio-Edit-Test: AI評価基準

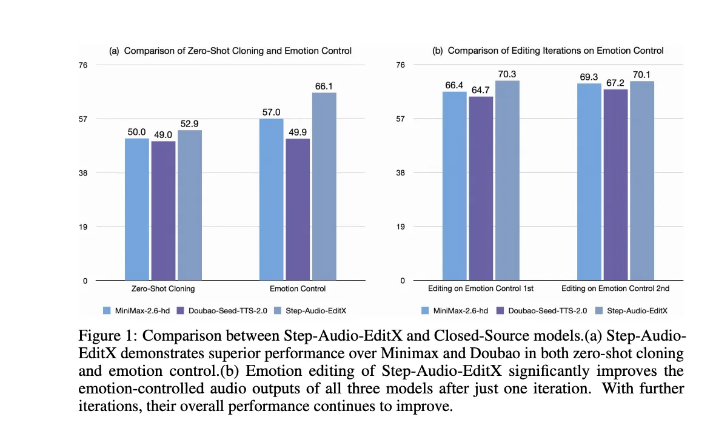

制御能力を数値化するため、チームはStep-Audio-Edit-Testというベンチマークを提案しました。このベンチマークでは、感情、スタイル、副言語の3つの次元から評価するためにGemini2.5Proが評価モデルとして使用されました。

結果は以下の通りです:

中国語の感情正確率は57.0%から77.7%に上昇;

スタイル正確率は41.6%から69.2%に上昇;

英語の結果も同様です。

副言語編集の平均得点も1.91から2.89に上昇し、主流の商用システムに近づいています。驚くべきことに、Step-Audio-EditXはGPT-4o mini TTS、ElevenLabs v2、豆包種子TTS2.0などの非オープンソースシステムにも顕著な改善をもたらすことがわかりました。

Step-Audio-EditXは、制御可能な音声合成における本格的な飛躍を示しています。従来の波形レベルの信号操作をあきらめ、離散的なトークンを基盤とし、大間隔学習と強化学習最適化を組み合わせることで、音声編集の体験が初めてテキスト編集ほどのスムーズさを達成しました。

技術とオープン性の観点から、StepFun AIはフルスタックオープンソース(モデル重みとトレーニングコードを含む)を選択し、音声編集研究の門檻を大幅に下げました。これにより、今後開発者は文章を修正するように、音声の感情、トーン、および副言語特性を正確に制御できる