アップル社の研究チームは、最新の論文で「チェックリストフィードバックに基づく強化学習(RLCF)」という革新的なトレーニング手法を提案しました。この方法では、従来の人工的ないいね評価メカニズムに代えて、具体的なタスクのチェックリストを使用し、大規模言語モデルが複雑な指示を実行する能力を大幅に向上させました。

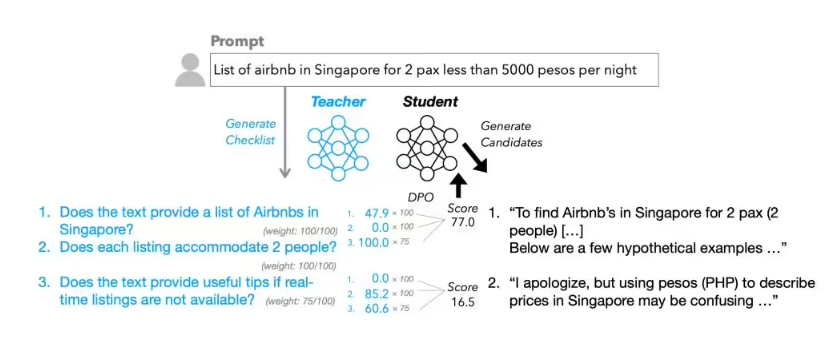

RLCFは「チェックリストフィードバックからの強化学習」という意味で、現在広く用いられている「人間のフィードバックによる強化学習(RLHF)」と対照的です。従来のRLHF方法は、主に人間が単純ないいねや悪い評価を行うことで、モデルを最適化していました。一方で、RLCFでは各ユーザーの指示ごとに詳細なチェックリストを作成し、0〜100点の基準で項目ごとに正確なスコアリングを行い、モデルの最適化の指針としています。

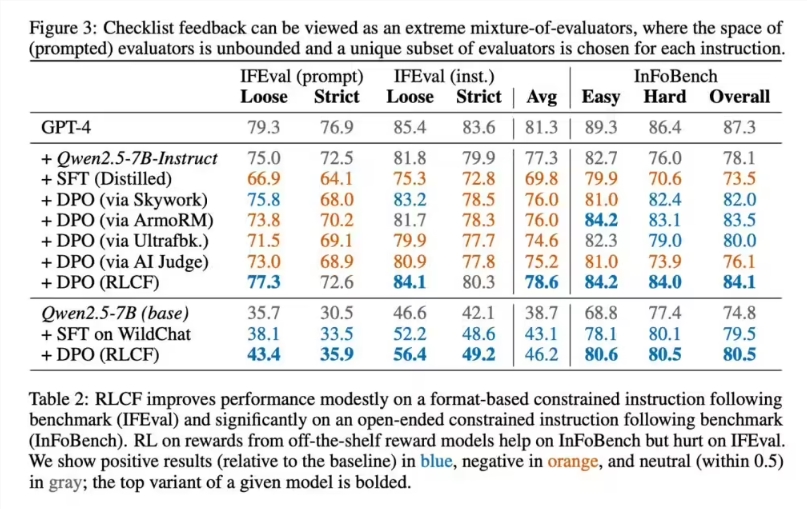

アップルの研究チームは、強指令追随モデルであるQwen2.5-7B-Instructをテスト対象とし、5つの一般的な評価ベンチマークで総合的な検証を行いました。テスト結果によると、RLCFはすべてのテストプロジェクトで性能向上を達成した唯一のトレーニング方案でした。

具体的なデータによると、FollowBenchテストでは硬性満足率が4ポイント上昇しました。InFoBenchスコアは6ポイント上昇し、Arena-Hard勝率は3ポイント増加しました。特定のタスクでは、性能向上の割合が最大で8.2%に達しました。これらのデータは、チェックリストフィードバック方法が複雑な多段階タスクの処理において特に優れていることを示しています。

技術的な実装において、アップルチームのチェックリスト生成プロセスには独自性があります。彼らはより大規模なQwen2.5-72B-Instructモデルを用い、既存の研究方法と組み合わせて、13万件の指示のために「WildChecklists」と呼ばれる専用データセットを構築しました。チェックリストの内容は明確な二値判断項目であり、例えば「スペイン語に翻訳されているか」など具体的な要求が含まれます。その後、大規模モデルが候補となる回答を一つずつスコアリングし、総合的な重み付け処理によりトレーニングの報酬信号を作成し、小規模モデルの学習と最適化を指導します。

ただし、アップルの研究者たちはこの方法の限界を率直に認めています。まず第一に、RLCFはより強力なモデルを評価基準として必要とするため、計算リソースが制限された環境では実施が困難になる可能性があります。第二に、この方法は複雑な指示実行能力の向上を目的として設計されており、安全性の整合性を目的としたものではないため、既存の安全性評価や調整メカニズムを置き換えることはできません。他のタイプのAIタスクにおけるRLCFの適用性についてはさらなる実験的な検証が必要です。

業界の専門家は、アップルが提案したRLCF方法がAIモデルのトレーニングに対して新しい考えを提供し、特に複雑な多段階タスクの処理において顕著な優位性を示していると見ています。技術のさらなる改善とともに、この方法は実際の応用においてより大きな役割を果たすことが期待されています。