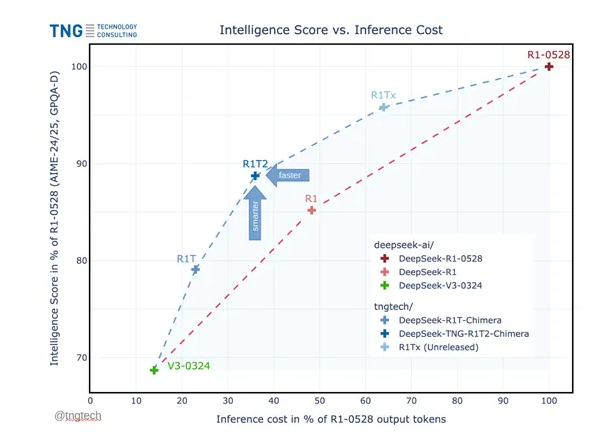

最近、ドイツの著名な技術コンサルティング会社TNGは、DeepSeekの強化版である「DeepSeek-TNG-R1T2-Chimera」をリリースしました。これは、深層学習モデルにおける推論効率と性能のさらなる大きな進歩を示しています。この新バージョンは、推論効率が200%向上し、独自のAoEアーキテクチャにより推論コストを顕著に削減しています。

独自のAoEアーキテクチャ

Chimeraバージョンは、DeepSeekのR1-0528、R1、V3-0324の3つのモデルを統合して開発され、新しいAoE(Adaptive Expert)アーキテクチャを採用しています。このアーキテクチャは、混合専門家(MoE)アーキテクチャを細かく最適化することで、モデルパラメータを効率的に利用し、推論性能を向上させ、トークン出力を節約します。

MTBenchやAIME-2024などの主要なテストベンチマークにおいて、Chimeraバージョンは通常のR1バージョンよりも優れた性能を示し、明確な推論能力と経済性を備えています。

MoEアーキテクチャの利点

AoEアーキテクチャについて詳しく説明する前に、混合専門家(MoE)アーキテクチャについて理解しておく必要があります。MoEアーキテクチャでは、Transformerの前馈層を複数の「専門家」として分割し、各入力トークンは一部の専門家のみにルーティングされます。この方法により、モデルの効率と性能が効果的に向上します。

例えば、2023年にMistralがリリースしたMixtral-8x7Bモデルは、アクティブなパラメータ数が13億に過ぎないにもかかわらず、700億のパラメータを持つLLaMA-2-70Bモデルと同等の性能を持ち、推論効率は6倍向上しています。

AoEアーキテクチャは、MoEの細粒度の特徴を利用し、既存の混合専門家モデルから特定の能力を持つサブモデルを構築することが可能です。親モデルの重みテンソルを補間および選択的に結合することによって、新しいモデルは優れた特性を保持しつつ、実際のニーズに応じて柔軟にパフォーマンスを調整できます。

研究者は、DeepSeek-V3-0324とDeepSeek-R1を親モデルとして選び、異なる微調整技術を用いることで、これらのモデルが推論能力和指示の遵守において卓越した性能を発揮できるようにしました。

重みの統合と最適化

新しいサブモデルを構築する過程で、研究者はまず親モデルの重みテンソルを準備し、重みファイルを解析して直接操作を行います。次に、重み係数を定義することで、親モデルの特徴を滑らかに補間および統合し、新しいモデルの変種を生成します。

統合の過程で、研究者は閾値制御と差異フィルタリング機構を導入し、重大な差異がある場合にのみ関連するテンソルを統合範囲に含めることで、モデルの複雑さと計算コストを削減します。

MoEアーキテクチャにおいて、ルーティング専門家テンソルは非常に重要な構成要素であり、推論中に入力トークンが選ぶ専門家モジュールを決定します。AoE手法は特にこれらのテンソルの統合に注目しており、ルーティング専門家テンソルの最適化により、サブモデルの推論能力を大幅に向上させることができることが研究者によって発見されました。

最終的に、PyTorchフレームワークを使用してモデルの統合を実現しました。統合された重みは新しい重みファイルに保存され、新たなサブモデルが生成され、効率性と柔軟性を備えています。

オープンソースの場所: https://huggingface.co/tngtech/DeepSeek-TNG-R1T2-Chimera