人工知能分野において、DeepSeekチームは最近、NSA(Native Sparse Attention)と呼ばれる革新的なスパースアテンション機構を発表しました。この技術の主要な目的は、特に最新のハードウェア向けに最適化することで、長文脈のトレーニングと推論の速度を向上させることです。これにより、トレーニングと推論の効率が大幅に向上します。

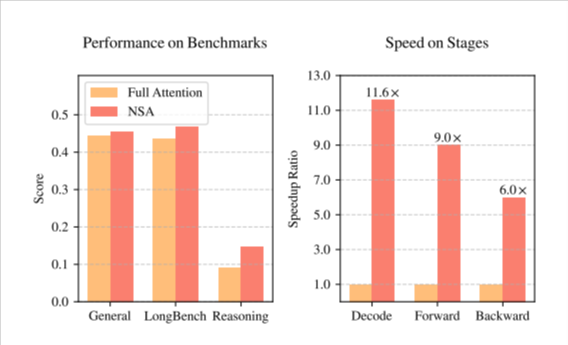

NSA技術の導入により、人工知能モデルのトレーニングに大きな変化がもたらされました。まず、最新の計算ハードウェアの特性を考慮した設計最適化により、推論速度が大幅に向上し、事前トレーニングのコストが効果的に削減されました。さらに重要なのは、速度とコストの向上を維持しながら、NSAは高いレベルのモデル性能を維持し、様々なタスクにおけるモデルのパフォーマンスに影響を与えないことです。

DeepSeekチームは、その研究において階層的なスパース戦略を採用し、アテンション機構を圧縮、選択、スライディングウィンドウの3つのブランチに分割しました。この設計により、モデルはグローバルコンテキストとローカル詳細を同時に捉えることができ、長文の処理能力が向上します。さらに、NSAはメモリアクセスと計算スケジューリングの最適化により、長文脈トレーニングの計算遅延とリソース消費を大幅に削減します。

一連の一般的なベンチマークテストにおいて、NSAはその優れた性能を示しました。特に長文脈タスクと指示ベースの推論において、NSAのパフォーマンスは完全アテンションモデルと同等か、場合によってはそれを上回りました。この技術の発表は、AIトレーニングと推論技術の飛躍的な進歩を示しており、将来の人工知能の発展に新たな動力をもたらすでしょう。

NSA論文(https://arxiv.org/pdf/2502.11089v1)。

要点:

🌟 NSA技術の導入により、長文脈トレーニングと推論の速度が大幅に向上し、事前トレーニングコストが削減されました。

🛠️ 階層的なスパース戦略を採用し、アテンション機構を圧縮、選択、スライディングウィンドウに分割することで、モデルの長文処理能力が向上しました。

📈 複数のベンチマークテストにおいて、NSAは優れた性能を示し、場合によっては従来の完全アテンションモデルを上回りました。