Meta FAIR研究所は最近、「Sparsh」という人工多感覚指先触覚感知技術を発表しました。この技術は、ロボットに人間に近い触覚感知能力を与えることができ、ロボット操作分野に革命的な変化をもたらすと期待されています。

Sparshモデルは自己教師あり学習方式を採用しており、46万枚以上の触覚画像を使用して事前学習を行います。人工によるデータ注釈は不要で、汎用的な触覚表現を学習できます。

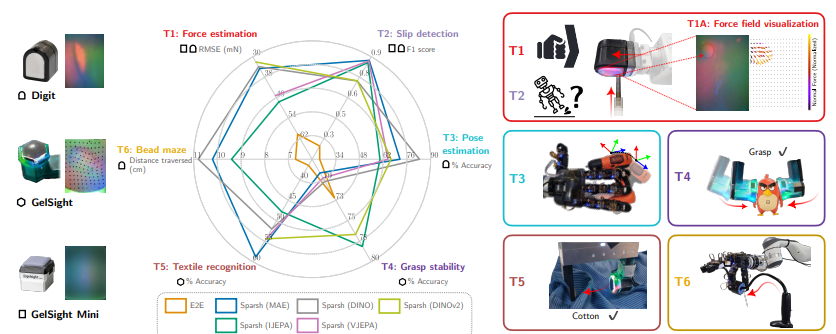

このモデルは、DIGIT、GelSight2017、GelSight Miniなど、さまざまな種類の視覚触覚センサーに対応しており、力推定、滑り検出、姿勢推定、把持安定性予測、織物認識など、触覚感知タスクにおけるロボットの性能を大幅に向上させます。研究者らは、さまざまなタスクにおける異なる触覚センサーとモデルの性能を評価するための、TacBenchという標準化されたベンチマークテストプラットフォームも構築しました。

テストの結果、SparshモデルはTacBenchの6つのタスクすべてで優れた性能を示しました。特にデータ量が限られている場合、従来の特定タスクおよび特定センサーモデルをはるかに凌駕する性能を発揮します。例えば、力推定と滑り検出タスクでは、わずか1%の注釈データを使用した場合でも、Sparshモデルは満足のいく結果を得ることができました。これは、Sparshがロボットが物体の物理的特性をより良く理解し、より精密な操作を行うのに役立つことを意味します。

Sparshモデルの発表は、AI触覚感知分野における大きなブレークスルーを意味します。今後、データの蓄積とモデルの更なる最適化により、Sparshはロボットと物理世界の相互作用の仕方を根本的に変え、より広範な分野でのロボット技術の応用を促進すると期待されています。

論文アドレス:

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/464969941_1107633400780143_7479102347328147009_n.pdf?_nc_cat=103&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=y8Ui1HEw3BQQ7kNvgFe-ePu&_nc_zt=14&_nc_ht=scontent-sjc3-1.xx&_nc_gid=AeaFsuZziasVwPfMQsEoZqu&oh=00_AYAMqxGq0ATCySDxZWB0ZT8BgSkogYmj13c9f3ytVtkmSg&oe=672DEEE4